Física/Texto completo

Introducción a la Física

Definición de la Física

La Física es la ciencia dedicada al estudio de las fuerzas que se dan en la naturaleza, en el más amplio sentido de la búsqueda del conocimiento.

También la Física es una ciencia natural que estudia las propiedades del espacio, el tiempo, la materia, la energía y sus interacciones. La Física es la ciencia dedicada al estudio de los fenómenos naturales.

Historia de la Física

Desde la más remota antigüedad las personas han tratado de comprender la naturaleza y los fenómenos que en ella se observan: el paso de las estaciones, el movimiento de los cuerpos y de los astros, los fenómenos climáticos, las propiedades de los materiales, etc. Las primeras explicaciones aparecieron en la Antigüedad y se basaban en consideraciones puramente filosóficas, sin verificarse experimentalmente. Algunas interpretaciones falsas, como la hecha por Ptolomeo en su famoso "Almagesto" - "La Tierra está en el centro del Universo y alrededor de ella giran los astros" - perduraron durante siglos.

La física es una de las más antiguas disciplinas académicas, tal vez la más antigua a través de la inclusión de la astronomía. En los últimos dos milenios, la física había sido considerada sinónimo de la filosofía, la química, y ciertas ramas de la matemática y la biología, pero durante la Revolución Científica en el siglo XVII surgió para convertirse en una ciencia moderna, única por derecho propio. Sin embargo, en algunas esferas como la física matemática y la química cuántica, los límites de la física siguen siendo difíciles de distinguir.

La revolución científica post-renacentista

En el Siglo XVI Galileo Galilei fue pionero en el uso de experiencias para validar las teorías de la Física. Se interesó en el movimiento de los astros y de los cuerpos. Usando instrumentos como el plano inclinado, descubrió la ley de la inercia de la dinámica, y con el uso de uno de los primeros telescopios observó que Júpiter tenía satélites girando a su alrededor y las manchas solares del Sol. Estas observaciones demostraban el modelo heliocéntrico de Nicolás Copérnico y el hecho de que los cuerpos celestes no son perfectos. En la misma época, las observaciones de Tycho Brahe y los cálculos de Johannes Kepler permitieron establecer las leyes que gobiernan el movimiento de los planetas en el Sistema Solar.

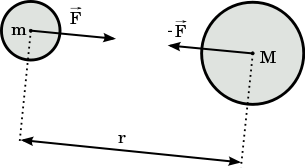

En 1687 Isaac Newton publicó los Principios Matemáticos de la Naturaleza, una obra en la que se describen las leyes clásicas de la dinámica conocidas como: Leyes de Newton; y la ley de la gravitación universal de Newton. El primer grupo de leyes permitía explicar la dinámica de los cuerpos y hacer predicciones del movimiento y equilibrio entre ellos, la segunda ley permitía demostrar las leyes de Kepler del movimiento de planetas y explicar la gravedad terrestre (de aquí el nombre de gravedad universal). En esta época se puso de manifiesto uno de los principios básicos de la Física, las leyes de la Física son las mismas en cualquier punto del Universo. El desarrollo por Newton y Leibniz del cálculo matemático proporcionó las herramientas matemáticas para el desarrollo de la Física como ciencia capaz de realizar predicciones. En esta época desarrollaron sus trabajos físicos como Robert Hooke y Christian Huygens estudiando las propiedades básicas de la materia y de la luz.

A finales del siglo XVII la física comienza a influenciar el desarrollo tecnológico permitiendo a su vez un avance más rápido de la propia física. El desarrollo instrumental (telescopios, microscopios y otros instrumentos) y el desarrollo de experimentos cada vez más sofisticados permitieron obtener grandes éxitos como la medida de la masa de la Tierra en el experimento de la balanza de torsión. También aparecen las primeras sociedades científicas como la Royal Society en Londres en 1660 y la Académie des Sciences en París en 1666 como instrumentos de comunicación e intercambio científico, teniendo en los primeros tiempos de ambas sociedades un papel preeminente las ciencias físicas.

Siglo XVIII: Termodinámica y óptica

A partir del Siglo XVIII Robert Boyle, Thomas Young y otros desarrollaron la termodinámica. En 1733 Daniel Bernoulli usó argumentos estadísticos, junto con la mecánica clásica, para extraer resultados de la termodinámica, iniciando la mecánica estadística. En 1798 Benjamin Thompson demostró la conversión del trabajo mecánico en calor y en 1847 James Prescott Joule formuló la ley de conservación de la energía.

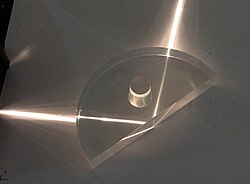

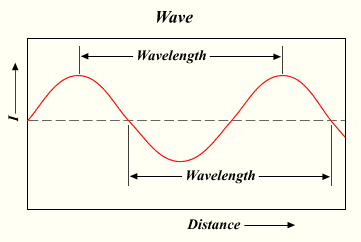

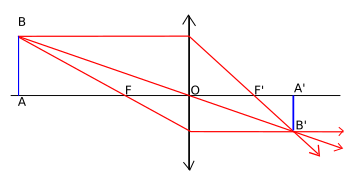

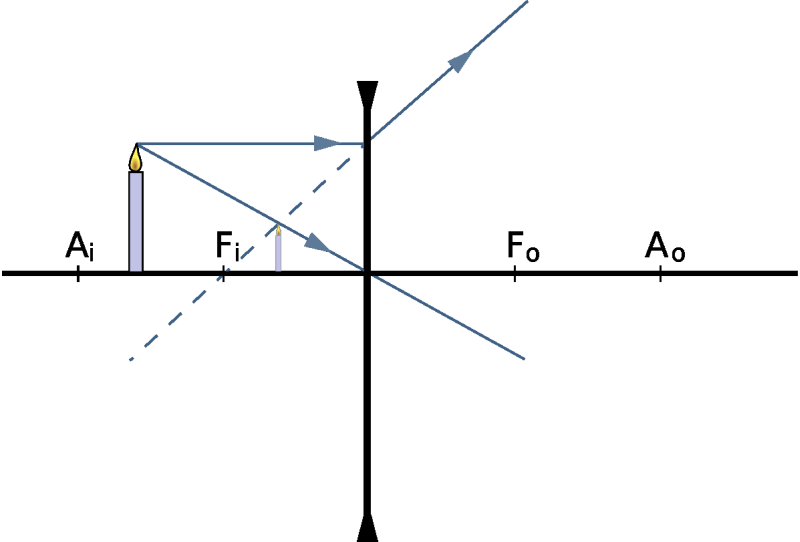

En el campo de la óptica el siglo comenzó con la teoría corpuscular de la luz de Isaac Newton expuesta en su famosa obra Opticks. Aunque las leyes básicas de la óptica geométrica habían sido descubiertas algunas décadas antes el siglo XVIII fue rico en avances técnicos en este campo produciéndose las primeras lentes acromáticas, midiéndose por primera vez la velocidad de la luz y descubriendo la naturaleza espectral de la luz. El siglo concluyó con el célebre experimento de Young de 1801 en el que se ponía de manifiesto la interferencia de la luz demostrando la naturaleza ondulatoria de ésta.

El siglo XIX: Electromagnetismo y la estructura de la materia

La investigación física de la primera mitad del siglo XIX estuvo dominada por el estudio de los fenómenos de la electricidad y el magnetismo. Coulomb, Luigi Galvani, Michael Faraday, Georg Simon Ohm y muchos otros físicos famosos estudiaron los fenómenos dispares y contraintuitivos que se asocian a este campo. En 1855 James Clerk Maxwell unificó las leyes conocidas sobre el comportamiento de la electricidad y el magnetismo en una sola teoría con un marco matemático común mostrando la naturaleza unida del electromagnetismo. Los trabajos de Maxwell en el electromagnetismo se consideran frecuentemente equiparables a los descubrimientos de Newton sobre la gravitación universal y se resumen con las conocidas, ecuaciones de Maxwell, un conjunto de cuatro ecuaciones capaz de predecir y explicar todos los fenómenos electromagnéticos clásicos. Una de las predicciones de esta teoría era que la luz es una onda electromagnética. Este descubrimiento de Maxwell proporcionaría la posibilidad del desarrollo de la radio unas décadas más tarde por Heinrich Rudolf Hertz en 1888.

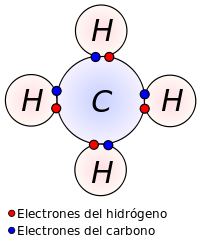

En 1895 Wilhelm Röntgen descubrió los rayos X, ondas electromagnéticas de frecuencias muy altas. Casi simultáneamente, Henri Becquerel descubría la radioactividad en 1896. Este campo se desarrolló rápidamente con los trabajos posteriores de Pierre Curie, Marie Curie y muchos otros, dando comienzo a la física nuclear y al comienzo de la estructura microscópica de la materia. En 1897 Joseph John Thomson descubrió el electrón, la partícula elemental que transporta la corriente en los circuitos eléctricos proponiendo en 1904 un primer modelo simplificado del átomo.

El siglo XX: La segunda revolución de la física

El siglo XX estuvo marcado por el desarrollo de la física como ciencia capaz de promover el desarrollo tecnológico. A principios de este siglo los físicos consideraban tener una visión cuasi completa de la naturaleza. Sin embargo pronto se produjeron dos revoluciones conceptuales de gran calado: El desarrollo de la teoría de la relatividad y el comienzo de la mecánica cuántica.

En 1905 Albert Einstein formuló la teoría de la relatividad espacial, en la cual el espacio y el tiempo se unifican en una sola entidad, el espacio-tiempo. La relatividad formula ecuaciones diferentes para la transformación de movimientos cuando se observan desde distintos sistemas de referencia inerciales a aquellas dadas por la mecánica clásica. Ambas teorías coinciden a velocidades pequeñas en relación a la velocidad de la luz. En 1915 extendió la teoría espacial de la relatividad para explicar la gravedad, formulando la teoría general de la relatividad, la cual sustituye a la ley de la gravitación de Newton.

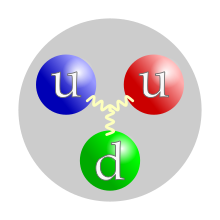

En 1911 Ernest Rutherford dedujo la existencia de un núcleo atómico cargado positivamente a partir de experiencias de dispersión de partículas. A los componentes de carga positiva de este núcleo se les llamó protones. Los neutrones, que también forman parte del núcleo pero no poseen carga eléctrica, los descubrió James Chadwick en 1932.

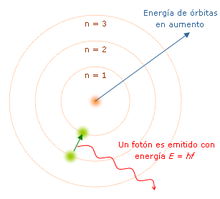

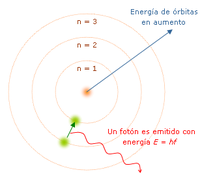

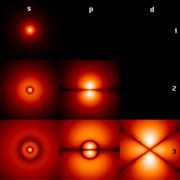

En los primeros años del Siglo XX Max Planck, Albert Einstein, Niels Bohr y otros desarrollaron la teoría cuántica a fin de explicar resultados experimentales anómalos sobre la radiación de los cuerpos. En esta teoría, los niveles posibles de energía pasan a ser discretos. En 1925 Werner Heisenberg y en 1926 Erwin Schrödinger y Paul Dirac formularon la mecánica cuántica, en la cual explican las teorías cuánticas precedentes. En la mecánica cuántica, los resultados de las medidas físicas son probabilidad|probabilísticos; la teoría cuántica describe el cálculo de estas probabilidades.

La mecánica cuántica suministró las herramientas teóricas para la física de la materia condensada, la cual estudia el comportamiento de los sólidos y los líquidos, incluyendo fenómenos tales como estructura cristalina, semiconductividad y superconductividad. Entre los pioneros de la física de la materia condensada se incluye Felix Bloch, el cual desarrolló una descripción mecano-cuántica del comportamiento de los electrones en las estructuras cristalinas (1928).

La teoría cuántica de campos se formuló para extender la mecánica cuántica de manera consistente con la teoría especial de la relatividad. Alcanzó su forma moderna a finales de los 1940s gracias al trabajo de Richard Feynman, Julian Schwinger, Tomonaga y Freeman Dyson. Ellos formularon la teoría de la electrodinámica cuántica, en la cual se describe la interacción electromagnética.

La teoría cuántica de campos suministró las bases para el desarrollo de la física de partículas, la cual estudia las fuerzas fundamentales y las partículas elementales. En 1954 Yang Chen Ning y Robert Mills desarrollaron las bases del modelo estándar. Este modelo se completó en los años 1970 y con él se describen casi todas las partículas elementales observadas.

La física en los albores del Siglo XXI

La física sigue enfrentándose a grandes retos, tanto de carácter práctico como teórico, a comienzos del siglo XXI. El estudio de los sistemas complejos dominados por sistemas de ecuaciones no lineales, tal y como la meteorología o las propiedades cuánticas de los materiales que han posibilitado el desarrollo de nuevos materiales con propiedades sorprendentes. A nivel teórico la astrofísica ofrece una visión del mundo con numerosas preguntas abiertas en todos sus frentes, desde la cosmología hasta la formación planetaria. La física teórica continúa sus intentos de encontrar una teoría física capaz de unificar todas las fuerzas en un único formulismo en lo que sería una teoría del todo. Entre las teorías candidatas debemos citar la teoría de supercuerdas.

División de la Física

La Física se divide para su estudio en dos grandes grupos, la física clásica y la física moderna. La física clásica no tiene en cuenta los efectos relativistas, descubiertos por Einstein, ni los efectos cuánticos, considerando la constante de Plank nula. La física moderna sí tiene en cuenta estos factores, dando lugar a la física relativista y a la física cuántica.

Física Teórica

Esta es una introducción a la física teórica la cual pueden encontrar en muchos libros aquí en wikibooks. Pero esta ese una manera mas fácil para entender a la física, desde una perspectiva teórica.

La física teórica se aprende en la Universidad y su estudio supone algún conocimiento previo de: física experimental, análisis matemático, álgebra vectorial, análisis vectorial y ecuaciones diferenciales sencillas.

La Física comienza con la cuidadosa observación de fenómenos físicos: como en la naturaleza o en los experimentos se presentan.

La observación de tales hechos sigue con la descripción mas precisa posible. Pongamos un ejemplo sencillo: para el continuo enfriamiento de agua a hielo. Para este fenómeno no se podría hacer mas un descubrimiento trivial: para el enfriamiento el agua entrega calor. Pero de aquí cabe una pregunta: "Cuanto calor?", respuesta: "La cantidad de calor depende de la masa del agua enfriada". - Como es la conexión entre masa y cantidad de calor? - "La cantidad de calor es proporcional a la masa" - Con esto comienza la "matematizacion" de la física: "proporcional" es un concepto matemático. Eso significa aqui, que el cociente entre la cantidad de calor y la masa siempre tiene el mismo valor. - Para finalizar se puede definir un nuevo concepto: el constante cociente de la cantidad de calor y la masa se lo llama "calor especifico" del agua en este caso. Pero con esto viene una nueva pregunta: " Tienen todas las sustancias el mismo calor especifico?" - Ni por coincidencia! - Después: "Es posible, el calor del agua - también la energía - transferirla y de donde proviene?" - y con eso estamos frente a una típica pregunta de la física teórica, que finalmente proviene de la teoría cinética del calor.

Ejemplo de una extraordinaria historia real

El astrónomo danés Tycho Brahe (1546-1601), el importante observador que perfeccionó el telescopio, observó como unos cuatro años la posición de los planetas desde un segundo plano a una parte del cielo fija y tomando precisas anotaciones sobre eso. Con los datos de esas anotaciones, Johannes Kepler (1571-1630) pudo deducir el movimiento planetario, una verbal-matemática descripción de los hechos. Lo que descubrió fue que:

- Los planetas se mueven en trayectorias elípticas, donde en uno de sus focos esta el Sol.

- El radio vector, la linea que une al Sol y a un planeta, cubre en el mismo tiempo el mismo espacio.

- La segunda potencia de un periodo de revolución de los planetas se comporta como la tercera potencia del gran semieje de su dirección elíptica.

La extracción de esos datos de Tycho Brahe no es siempre descrito en la Física, pese a que es un dato relevante. Sobre eso también se preguntó Kepler, sobre la causa física del movimiento y sus leyes. (La escolástica de la edad media aceptaba aun, que los planetas eran dirigidos por los ángeles por sus recorridos hacia la Tierra) El supuso que entre los planetas y el Sol - sobretodo entre dos masas - debería haber una fuerza atrayente.

Tycho Brahe fue aquí solo el observador, Johannes Kepler el interprete y el primer interlocutor de la razón física del movimiento planetario.

A partir de las leyes de Kepler, Isaac Newton (1643-1727), pudo deducir las leyes de la Gravitación: entre dos masas opera una fuerza de atracción, que es proporcional al producto de las masas e inversamente proporcional al cuadrado de la distancia. Issac Newton hizo aquí de físico teórico.

Un triunfo de la física teórica fue también que en 1846 el astrónomo Johann Galle pudiera descubrir el planeta Neptuno, después de que Urbain Le Verrier calculo su posición por la interferencia del camino del planeta Urano.

A la genialidad del físico teórico pertenecen también, que si antes se hubiera deducido la desconocida (o no clara) consecuencia de su resultado, la experiencia podría ponerse a prueba nuevamente. Ahi un impresionante ejemplo: Albert Einstein baso su Teoria de la Relatividad General del conocido, pero no claro hecho, que un cuerpo en caída libre es ingrávido, que significa, que masas pesadas y lentas deben ser proporcionales a sus cuerpos. Como consecuencia de su teoría resulto la conocida, pero no clara, movimiento de perihelio de Mercurio, cuyo camino elíptico rota alrededor del Sol.

Todo el mundo se fue en contra de la Teoría de la Relatividad General de Einstein cuando dijo que se producía una curvatura en un rayo de luz que pasa junto a las cercanías del Sol. Ese efecto puede ser observado en eclipses reales de Sol.

Para terminar un ultimo indicación de los significados "prácticos" de la física teórica: La moderna y complicada tecnología de ahora seria inconcebible sin la física teórica. ¡No hay nada practico sin una buena teoría!.

Concepto de Modelo

La Física utiliza modelos matemáticos para describir los fenómenos naturales. Es decir, que las leyes y principios que enuncia son sólo aproximaciones y no algo preciso.

Los físicos observan un fenómeno, acumulan datos y luego intentan formular una expresión matemática, generalmente basadas en conocimientos anteriores, que se adecue a los datos experimentales. Para hacer un modelo necesitas observar a la naturaleza y así entender más de los fenómenos.

Para mayor información ver:

Unidades y medidas

Cantidades dimensionales

Corresponden a ciertas magnitudes que están asociadas a las dimensiones. Se miden en unidades de longitud, área, tiempo, espacio, etc.

Cantidades adimensionales

Corresponden a magnitudes que pueden ser expresadas sin necesidad de una unidad de medida, pueden ser cocientes entre cantidades dimensionales. Ejemplo de estas son los grados de un ángulo o también las constantes, como la relación de la masa entre protón y electrón.

Magnitud

Se llama magnitud a la propiedad de la física que es medida. Pueden ser clasificadas en dos clases:

- magnitudes fundamentales y

- magnitudes derivadas

Magnitudes fundamentales

Son aquellas que se definen en función de otras magnitudes físicas y que sirven de base para obtener las demás magnitudes utilizadas en la física. Son las que no derivan de otras, única es su especie, son el cimiento de la física, y no se pueden ni multiplicar o dividir entre otras.

Magnitudes derivadas

Son las que resultan de multiplicar o dividir entre si las magnitudes fundamentales.

Medir

Medir es comparar una magnitud con otra que se utiliza como patrón. Este patrón es una magnitud de valor conocido y perfectamente definido que se usa como referencia para la medida. Así, cuando medimos una distancia, el patrón sería la cinta métrica, y la medida sería el resultado de comparar la distancia que estamos midiendo, con la cinta métrica.

Sistemas de medidas

Un sistema de medidas es un conjunto que consiste en unidades de medida. Definen un conjunto básico de unidades de medida a partir del cual se derivan el resto. Existen varios sistemas de unidades:

Sistema Métrico Decimal

El primer sistema de unidades bien definido que hubo en el mundo fue el Sistema Métrico Decimal, implantado en 1795 como resultado de la Convención Mundial de Ciencia celebrada en París, Francia; este sistema tiene una división decimal y sus unidades fundamentales son: el metro, el kilogramo-peso y el litro.

Sistema MKS

Tiene su origen en 1902 de la mano del ingeniero italiano Giovani Giorgi siendo adoptado por la Comisión Electrotécnica Internacional en París en el año 1935. Este sistema también recibe el nombre de MKS, cuyas iniciales corresponden al metro, al kilogramo y al segundo como unidades de longitud, masa y tiempo respectivamente.

Sistema Usual en Estados Unidos (EIA)

Se basa en el sistema inglés, y es muy familiar para todos en Estados Unidos. Usa el pie como unidad de longitud, la libra como unidad de peso o fuerza, y el segundo como unidad de tiempo. En la actualidad, el SUEU está siendo sustituido rápidamente por el sistema internacional, en la ciencia, la tecnología, y en algunos deportes.

Debido a que en el mundo científico se buscaba un solo sistema de unidades que resultara práctico, claro y de acuerdo con los avances de la ciencia. En 1960 científicos y técnicos de todo el mundo se reunieron en Ginebra, Suiza, y acordaron adoptar el llamado Sistema Internacional de Unidades (SI).

Este sistema se basa en el llamado MKS. El Sistema Internacional tiene como magnitudes y unidades fundamentales las siguientes: para longitud el metro (m), para masa el kilogramo (kg), para tiempo el segundo (s), para temperatura al Kelvin (K), para intensidad de corriente eléctrica al ampere (A), para la intensidad luminosa la candela (cd) y para cantidad de sustancia el mol

Unidades

Las unidades del Sistema Internacional de Unidades fueron fijadas en la XI Conferencia General de Pesas y Medidas de París (1960).

| Magnitud | Unidades | Dimensión | Simbolo | Descripción |

|---|---|---|---|---|

| Longitud | Metro | L | m | Unidad de longitud, se definió originalmente como la diezmillonésima parte del cuadrante del meridiano terrestre. Más tarde se estableció un metro patrón de platino iridiado que se conserva en París. En la actualidad, el metro se define como la longitud igual a 1.650.763,73 longitudes de onda, en el vacío, de la radiación correspondiente a la transición entre los niveles 2p10 y 5d5, del átomo de criptón 86. Ahora se define al metro como la longitud de la trayectoria recorrida por la luz en el vacío durante un intervalo de tiempo de 1/299,792,458 de segundo. |

| Masa | Kilogramo | m | Kg | Unidad de masa, es la masa de un cilindro de platino iridiado establecido en la III Conferencia General de Pesas y Medidas de París. También se define al gramo (milésima parte del kilogramo) como la masa de un centímetro cúbico de agua destilada cuando tiene la mayor densidad, esto sucede a cuatro grados centígrados. |

| Tiempo | Segundo | t | s | Unidad de tiempo, originalmente, el segundo fue definido como 1/86400 del día solar medio. Se llama día solar verdadero el tiempo transcurrido entre dos pasos consecutivos del Sol por el meridiano de un lugar; pero como no todos los días son de igual duración en el transcurso de un año, se toma un día ficticio, llamado día solar medio, cuya duración es tal que, al cabo del año, la suma de todos estos días ficticios es la misma que la de los días reales. Actualmente se define como la duración de 9.192.631.770 períodos de la radiación correspondiente a la transición entre los dos niveles hiperfinos del estado fundamental del átomo de cesio 133. |

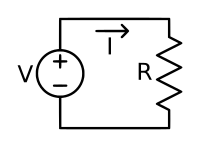

| Intensidad de corriente eléctrica | Amperio | A | A | Es la intensidad de corriente eléctrica constante que, mantenida en dos conductores paralelos rectilíneos, de longitud infinita, de sección circular despreciable y colocados en el vació a uno contra otro a una distancia de un metro uno de otro, produce entre estos dos conductores una fuerza igual a 2x10-7 newton por metro de longitud.[1] |

| Temperatura termodinámica | Kelvin | θ | K | Es la unidad de temperatura termodinámica, es la fracción 1/273,16 de la temperatura termodinámica del punto triple del agua. Este mismo nombre y símbolo son utilizados para expresar un intervalo de temperatura. |

| Cantidad de sustancia | mol | N | mol | Es la cantidad de sustancia de un sistema que contiene tantas entidades elementales como átomos hay en 0,012 kilogramo de carbono 12. |

| Intensidad luminosa | Candela | J | cd | Es la intensidad luminosa, en la dirección perpendicular de una superficie de 1/600000 metros cuadrados de un cuerpo negro a la temperatura de solidificación del platino, bajo la presión de 101.325 newton por metro cuadrado. |

Otras unidades

Newton (N)

Usado para medir la fuerza. Es una unidad derivada equivalente a la fuerza necesaria para acelerar un kilogramo de masa a un metro por segundo cada segundo, 1 kilogramo fuerza equivale a 9 newton

Joule

Un joule equivale a la cantidad de trabajo efectuado por una fuerza de 1 Newton actuando a través de una distancia de 1 metro. En 1948 el joule fue adoptado por la Conferencia Internacional de Pesas y Medidas como unidad de energía.

El joule también es igual a 1 vatio por segundo (W·s), por lo que eléctricamente es el trabajo realizado por una diferencia de potencial de 1 voltio y con una intensidad de 1 Amperio durante un tiempo de 1 segundo.

Formula despejada

Donde representa newtons; , metros; : kilogramos; : segundos.

Equivalencias:

- 1 vatio-hora = 3.600 joules.

- 1 joule = 0,24 calorías (no confundir con kcal).

- 1 caloría termoquímica (calth) = 4,184 J

- 1 Tonelada equivalente de petróleo = 41.840.000.000 joules = 11.622 kilovatio hora.

- 1 Tonelada equivalente de carbón = 29.300.000.000 joules = 8.138,9 kilovatio hora.

Referencias

Conversión de unidades en el Sistema Internacional

Longitud

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pulgada | milímetro (mm) | 25.4 |

| pulgada | metro (m) | 0.0254 |

| pie (ft) | metro (m) | 0.3047 |

| yarda (yd) | metro (m) | 0.9144 |

Área

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pie cuadrado (ft 2) | metro cuadrado | 0.09290 |

| pulgada cuadrado | milímetro cuadrado | 645.2 |

| pulgada cuadrado | metro cuadrado | 0.0000006452 |

| yarda cuadrada | metro cuadrado | 0.08361 |

Volumen

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pulgada cubica | metro cubico | 0.00001639 |

| pie cubico | metro cubico | 0.02832 |

| yarda cubica | metro cubico | 0.7646 |

| galòn (Canada) | metro cubico | 4.546 |

| galòn (Canada) | litro | 0.004546 |

| galòn (EUA) | metro cubico | 3.785 |

| galòn (EUA) | litro | 0.003785 |

Masa

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pulgada | milímetro (mm) | 25.4 |

| pulgada | metro (m) | 0.0254 |

| pie (ft) | metro (m) | 0.3047 |

| yarda (yd) | metro (m) | 0.9144 |

Fuerza

| Imperial | Internacional | Equivalencia |

|---|---|---|

| kilopontio | kilogramo | 453.6 |

| kilopontio | Newton | 4448 |

| libra | kilogramo | 0.4536 |

| libra | Newton | 4.448 |

Energía

| Imperial | Internacional | Equivalencia |

|---|---|---|

| Unidad Termica Britanica | joule | 1056 |

| Kilowatt Hora | joule | 3,600,000 |

Temperatura

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pulgada | ||

| pulgada | ||

| pie (ft) | ||

| yarda (yd) |

Presión o Tensión

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pulgada | ||

| pulgada | ||

| pie (ft) | ||

| yarda (yd) |

Momento Flexor o Tensor

| Imperial | Internacional | Equivalencia |

|---|---|---|

| pulgada | ||

| pulgada | ||

| pie (ft) | ||

| yarda (yd) |

Fuente

http://www.inti.gob.ar/cirsoc/pdf/tabla_conversion.pdf

Mecánica clásica

- Principio de conservación de la cantidad de movimiento

- Principio de conservación de la energia

- Principio de conservación del momento angular

- Descomposición de la energía cinética

- Introducción al Campo gravitatorio

- Energía potencial en un campo gravitatorio

- Leyes de Kepler

- Centro de gravedad

- Equilibrio y reposo

- Equilibrio de un sólido rígido

- Equilibrio de un punto en un campo de fuerzas

- Tipos de equilibrio

- Rozamiento

Cinemática

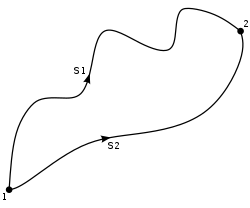

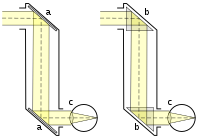

La cinemática es una rama de la física dedicada al estudio del movimiento de los cuerpos en el espacio, sin atender a las causas que lo producen (lo que llamamos fuerzas). Por tanto la cinemática sólo estudia el movimiento en sí, a diferencia de la dinámica que estudia las interacciones que lo producen. El Análisis Vectorial es la herramienta matemática más adecuada para ellos

En cinemática distinguimos las siguientes partes:

La magnitud vectorial de la cinemática fundamental es el "desplazamiento" , que experimenta un cuerpo durante un lapso Δt. Como el desplazamiento es un vector, por consiguiente, sigue la ley del paralelogramo, o la ley de suma vectorial. Asi si un cuerpo realiza un desplazamiento "consecutivo" o "al mismo tiempo" dos desplazamientos y , nos da un desplazamiento igual a la suma vectorial de a+b como un solo desplazamiento. ( )

Dos movimientos al mismo tiempo entran principalmente, cuando un cuerpo se mueve respecto a un sistema de referencia y ese sistema de referencia se mueve relativamente a otro sistema de referencia. Ejemplo: El movimiento de un viajero en un tren en movimiento, que esta siendo visto por un observador desde el terraplén. O cuando uno viaja en coche y observa las montañas y los árboles a su alrededor.

Observación sobre la notación: en el texto y en la ilustración se nombra a los vectores con letras negrillas y cursivas. En las fórmulas y ecuaciones, que se escriben con TeX, son vectores los que tienen una flecha sobre sus letras

Conceptos

Modelo físico: Para estudiar la realidad, los físicos se sirven de 'modelos' que, con cierta aproximación y en determinadas condiciones, corresponden con ella. Se usan para realizar cálculos teóricos. Así, puede modelizarse un balón con una esfera para, por ejemplo, calcular su volumen con cierta aproximación conociendo su radio aproximado, aunque no es exactos.

Punto: Es un modelo físico. Se refiere a un elemento de volumen despreciable (se considerará sin volumen) situado en el espacio (en 3D. Busca 'espacio euclidiano' para más detalles).

Posición: Llamamos posición de un punto a su localización con respecto a un sistema de referencia (lo que en física se llama 'observador').

Sistema de referencia: Es aquel sistema coordenado con respecto al cual se da la posición de los puntos y el tiempo (a determinadas velocidades el tiempo cambia, buscad la paradoja de los gemelos). Profundizaremos más en este tema cuando se aborde el de Movimiento relativo.

Tiempo: Por nuestro lenguaje parece complicado de definir. Los griegos dieron una solución que, por ahora, nos puede valer. Llamamos tiempo al contínuo transcurrido entre dos instantes.

Partícula puntual: Es un modelo físico. Se refiere a un elemento de tamaño diferencial (muy pequeño) y masa concentrada en su posición.

Sólido rígido o, simplemente, sólido: Es otro modelo físico. Puede definirse de varias formas. La más usada es la que lo hace como un cuerpo cuyas distancias entre partículas permanecen constantes con el tiempo. Aunque ésto no ocurre en la realidad, para esfuerzos moderados una mesa seguira siendo rígida, pero un globo puede no responder a éste modelo. Diariamente escuchamos los conceptos de rapidez y aceleración como velocidad y aceleración solamente. Pero en física la velocidad y la aceleración son vectores, por lo que es claro y necesario su diferenciación y entendimiento. De aquí en adelante (más por costumbre que por ganas) llamaremos tanto a la rapidez y a la aceleración solamente como velocidad y aceleración (a menos que se especifique lo contrario). (velocidad y rapidez no son lo mismo!) la rapidez es una magnitud escalar, en cambio la velocidad es una magnitud vectorial. Además la rapidez se define como el modulo de la velocidad.

En física, velocidad es la magnitud física que expresa la variación de posición de un objeto en función del tiempo, o distancia recorrida por un objeto en la unidad de tiempo. Se suele representar por la letra . La velocidad puede distinguirse según el lapso considerado, por lo cual se hace referencia a la velocidad instantánea, la velocidad promedio, etc. En el Sistema Internacional de Unidades su unidad es el metro por segundo ó .

En términos precisos, para definir la velocidad de un objeto debe considerarse no sólo la distancia que recorre por unidad de tiempo sino también la dirección y el sentido del desplazamiento, por lo cual la velocidad se expresa como una magnitud vectorial.

Velocidad

Si cubre una masa puntual en un punto P en un tiempo el tramo , se llamará al cociente su velocidad media en el intervalo de tiempo o en el tramo .

Se observa que aquí no es el desplazamiento, sino la longitud de arco: es el camino recorrido.

La llamamos velocidad media porque la masa puntual no se mueve por el trayecto uniforme trazado. O sea estamos tomando sólo los puntos final e inicial para hacer los cálculos.

Hagamos el trayecto como Δs (de manera diferencial, o sea infinitesimal), al igual que al intervalo de tiempo Δt. Para Δs cercano a cero (o Δt cercano a cero, que tienda a cero) el cociente Δs/Δt como valor al límite, nos da la velocidad v de la masa puntual en el punto P, así:

En el análisis se puede calcular ese valor al límite también como ds/dt. Así:

Velocidad media o velocidad promedio

La velocidad media o velocidad promedio informa sobre la velocidad en un intervalo dado. Se calcula dividiendo el desplazamiento (delta x) por el tiempo transcurrido (delta t):

Por ejemplo, si un objeto ha recorrido una distancia de 1 metro en un lapso de 31,63 segundos, el módulo de su velocidad media es:

Al módulo de la velocidad se le llama rapidez.

Velocidad vectorial

Vamos a ver ahora a una partícula, que atraviesa un espacio en una curva. Para el tiempo t se halla en P, para el tiempo t + Δt en Q. El lugar del punto esta descrito por su vector posición 'r'. Esta es una función de t y esta descrita por una función vectorial 'r'(t).

Así:

y

donde i, j y k son los vectores unitarios de los ejes de coordenadas.

El desplazamiento de la partícula en un determinado intervalo de tiempo es:

El cociente Δr/Δt es la velocidad media (vectorial) vm de la partícula en el intervalo de tiempo Δt. Es

Aquí es (mirar arriba: rapidez y aceleración) Δx/Δt la rapidez media de la partícula paralela al eje X, Δy/Δt la rapidez media paralela al eje Y y Δz/Δt la rapidez media paralela al eje Z en un intervalo Δt.

El vector resultante, del cociente Δr/Δt para Δt cercano a cero, se llama velocidad vP = v'(t) de la partícula en P o en el tiempo t.

La función vectorial v'(t) es la primera derivada de la función de posición r(t) en el tiempo.

Como se ve, son las componentes escalares del vector v(t) idénticos con la velocidad instantánea paralela a los ejes:

El recta en el punto P en la dirección del vector vP se llama La Tangente a la curva en P

Velocidad instantánea

Informa sobre la velocidad en un punto dado.

En forma vectorial, la velocidad es la derivada (tangente) del vector posición respecto del tiempo:

donde es un versor (vector de módulo unidad) de dirección tangente a la trayectoria de cuerpo en cuestión y es el vector posición, ya que en el límite los diferenciales de espacio recorrido y posición coinciden.

Unidades de velocidad

- Metro por segundo (m/s), unidad de velocidad del Sistema Internacional de Unidades

- Kilómetro por hora (km/h) (uso coloquial)

- Kilómetro por segundo (km/s) (uso coloquial)

Referencias

La aceleración es la magnitud física que mide la tasa de variación de la velocidad respecto del tiempo. Las unidades para expresar la aceleración serán unidades de velocidad divididas por las unidades de tiempo (en unidades del Sistema Internacional generalmente).

No debe confundirse la velocidad con la aceleración, pues son conceptos distintos, acelerar no significa ir más rápido, sino cambiar de velocidad.

Se define la aceleración media como la relación entre la variación o cambio de velocidad de un móvil y el tiempo empleado en dicho cambio:

Donde a es aceleración, y v la velocidad final en el instante t, la velocidad inicial en el instante t0.

La aceleración instantánea, que para trayectorias curvas se toma como un vector, es la derivada de la velocidad (instantánea) respecto del tiempo en un instante dado (en dos instantes cercanos pero diferentes el valor puede cambiar mucho):

Puesto que la velocidad instantánea v a su vez es la derivada del vector de posición r respecto al tiempo, se tiene que la aceleración vectorial es la derivada segunda respecto de la variable temporal:

aceleración

Tomemos luego una masa puntual que tiene en el punto P y en el tiempo t la velocidad v; y en el tiempo t + Δt y la velocidad v + Δv. Podemos calcular el cociente Δv/Δt como la aceleración media am de la masa puntual en el intervalo de tiempo Δt:

Para Δt cercano a cero se aspira a que ese cociente tenga un valor límite, la aceleración a de la masa puntual para el tiempo t.

Para ese valor límite, se puede simplificar:

Es el camino s descrito como una función analítica del tiempo t, así s=s(t), así es la función de velocidad v(t) la primera derivada de la función s(t) con respecto al tiempo, la función de aceleración a(t) es la segunda derivada. La derivación con respecto al tiempo se puede también escribir como un punto sobre las variables.

En sentido contrario se puede encontrar la función de velocidad y la función de la trayectoria a través de la integración:

En las integrales indefinidas de debe aumentar una constante que puede ser conocida con las condiciones iniciales del problema.

Ejemplo: aceleración constante g. Esto es, tiempo t=0 verticalmente de arriba abajo, tiene la velocidad v0 y sus coordenadas s0:

Componentes intrínsecas de la aceleración: aceleraciones tangencial y normal

Existe una descomposición geométrica útill del vector de aceleración de una partícula, en dos componentes perpendiculares: la aceleración tangencial y la aceleración normal. La primera da cuenta de cuanto varía el módulo del vector velocidad o celeridad. La aceleración normal por el contrario da cuenta de la tasa de cambio de la dirección velocidad:

Donde es el vector unitario y tangente a la trayectoria del mismo sentido que la velocidad. Usando las fórmulas de geometría diferencial de curvas se llega a que la expresión anterior es igual a:

Donde at es la aceleración tangencial, an es la aceleración normal y los vectores que aparecen en la anterior expresión se relacionan con los vectores del Triedro de Frênet-Serret que aparece en la geometría diferencial de curvas del siguiente modo:

- es el vector unitario tangente a la curva.

- es el vector normal (unitario) de la curva.

- es el vector velocidad angular que es siempre paralelo al vector binormal de la curva.

Aceleración

Análogamente vamos ahora a definir la función vectorial de la aceleración:

La función vectorial de la aceleración proviene de las componentes escalares de la función velocidad y de la función posición, así:

Como se conoce, son las componentes escalares del vector velocidad igual a la dirección de la velocidad instantánea en los ejes de coordenadas. En sentido contrario se puede hallar por integración las correspondientes funciones. Ejemplo: Para la caída libre con velocidad inicial v0 de un punto con el vector posición r0 (vertical o lanzamiento curvo). Cuando el eje Z (vector unitario k) esta dirigido verticalmente hacia abajo, es

Mientras el vector velocidad siempre tiene dirección tangencial, puede estar dirigido opcionalmente el vector aceleración. En un análisis profundo, la aceleración se descompone en dos componentes, en la una dirección es tangencial (aceleración tangencial) y la otra está en dirección vertical (aceleración normal). La aceleración tangencial cambia solo el valor de la velocidad (esta es la rapidez) Para esta descomposición de los vectores de la aceleración introducimos la curva s, este es el largo de la trayectoria, que recorre la partícula en la curva. Este arco cuenta con un punto cero escogido, que de todas formas aquí no juega ningún papel, aquí solo necesitamos el diferencial ds del arco. Además introducimos el vector unitario tangencial t y hacemos uso de la geometría diferencial. El vector unitario tangente t es el vector

así denominado, es igual al vector v dividido para su módulo v. Este módulo es igual a la rapidez y es otra vez el desplazamiento sobre la curva sobre el tiempo. Así es:

Si diferenciamos para el tiempo tenemos que

Aquí la longitud del vector unitario tangencial t es constante (cercano a 1), esta el vector desplazamiento dt/ds - cuando no es igual a cero - verticalmente hacia t.

De la geometría diferencial tenemos, que el vector desplazamiento dt/ds

- tiene la dirección del vector unitario normal n y

- el valor k = 1/ρ

De aquí es k la curvatura de la curva en el punto observado y ρ su radio de curvatura. El vector unitario normal n es dirigido hacia (momentáneamente) un punto medio de la curvatura (hacia dentro).

Siguiendo esto

Con esto nos da como resultado

El vector a está entre t y n' dirigido, en el plano de la curva en un determinado punto. El módulo de la aceleración tangencial es - como se esperaba:

el módulo de la aceleración normal es

Este par de ecuaciones tienen su interpretación: La aceleración de una partícula da lugar a la aparición de una fuerza. La dirección de esa fuerza determina la dirección de la aceleración. La componente tangencial de la aceleración causa un cambio en la velocidad, la componente normal de la aceleración causa la curvatura de la curva. El radio de curvatura de la curva en un determinado punto resulta de la aceleración normal y de la velocidad así:

Movimiento circular

Una partícula P se mueve en una circunferencia. Colocamos un eje de coordenadas XY y en el origen O del sistema de coordenadas en el centro de la circunferencia.

Entonces es

Análogo a la velocidad y a la aceleración podemos definir la velocidad angular ω así

y a la aceleración angular α

Cuando t = 0 es también φ = 0, entonces es

Movimiento circular uniforme

Un movimiento circular con velocidad angular constante se lo llama uniforme. Entonces

La ecuación del vector posición es

Con esto nos da la velocidad

y

Efectuando el producto escalar entre los vectores r y v obtenemos:

Con lo cual resulta que los vectores r y v son perpendiculares. Para la aceleración tenemos que

y así

La aceleración esta dirigida hacia O (aceleracion centripeta), y su modulo es constante.

Movimiento circular uniformemente acelerado

Aqui la aceleración angular α es constante y también ω(0) = 0

También, cuando φ(0)=0, así para el angulo de rotación

Así tenemos también que

y

o

Así, podemos deducir que la componente radial de la aceleracion (y su dirección) es

y su componente tangencial es

La velocidad angular como medida de direccion

A veces es muy útil ver a la velocidad angular como medida de la direccion y representarlo a través de un en el eje de

Ecuaciones de Movimiento en un sistema de coordenadas polares

Velocidad en coordenadas Polares

La velocidad v de una partícula material puede descomponerse en distintos tipos de componentes. Es usual e importante que se descomponga en componentes que tengan la dirección de los ejes de coordenadas, así se obtiene en la forma siguiente:

Otra alternativa puede ahora ser representado en un eje XY

Sistema de coordenadas

Un sistema de coordenadas es un conjunto de valores que permiten definir inequívocamente la posición de cualquier punto de un espacio euclídeo (o más generalmente variedad diferenciable). En física clásica se usan normalmente sistemas de coordenadas ortogonales, caracterizados por un punto denominado origen y un conjunto de ejes perpendiculares que constituyen lo que se denomina sistema de referencia Podemos llamarla bidimensional.

también, todo lo que presenta movimiento se puede medir bajo un sistema de referencia.

Sistemas usuales

Sistema de coordenadas cartesianas

El sistema de coordenadas cartesianas es aquel que formado por dos ejes en el plano, tres en el espacio, mutuamente perpendiculares que se cortan en el origen. En el plano, las coordenadas cartesianas o rectangulares x e y se denominan respectivamente abscisa y ordenada.

Sistema de coordenadas polares

Las coordenadas polares se definen por un eje que pasa por el origen (llamado eje ecopolar). La primera coordenada es la distancia entre el origen y el punto considerado, mientras que la segunda es el ángulo que forman el eje polar y la recta que pasa por ambos puntos.

Sistema de coordenadas cilíndricas

El sistema de coordenadas cilíndricas es una generalización del sistema de coordenadas polares plano, al que se añade un tercer eje de referencia perpendicular a los otros dos. La primera coordenada es la distancia existente entre el origen y el punto, la segunda es el ángulo que forman el eje y la recta que pasa por ambos puntos, mientras que la tercera es la coordenada que determina la altura del cilindro.

Sistema de coordenadas esféricas

El sistema de coordenadas esféricas está formado por tres ejes mutuamente perpendiculares que se cortan en el origen. La primera coordenada es la distancia entre el origen y el punto, siendo las otras dos los ángulos que es necesario girar para alcanzar la posición del punto.

Movimiento rectilíneo uniforme

Un movimiento es rectilíneo cuando describe una trayectoria recta y uniforme cuando su velocidad es constante en el tiempo, es decir, su aceleración es nula. Esto implica que la velocidad media entre dos instantes cualesquiera siempre tendrá el mismo valor. Además la velocidad instantánea y media de este movimiento coincidirán.

Ecuaciones del movimiento

Sabemos que la velocidad es constante.

Cálculo del espacio recorrido

Sabiendo que la velocidad es constante y según la definición de velocidad:

tenemos:

despejando términos:

integrando:

realizando la integral:

Donde es la constante de integración, que corresponde a la posición del móvil para , si en el instante , el móvil está en el origen de coordenadas, entonces . Esta ecuación determina la posición de la partícula en movimiento en función del tiempo.

Cálculo de la aceleración

Según la ecuación del movimiento y la definición de aceleración tenemos:

esto es:

sabiendo que la velocidad no varía con el tiempo, tenemos:

La aceleración es nula, como ya se sabía.

El reposo

Se debe notar que el reposo es un caso de movimiento rectilíneo uniforme en el que

Referencias

Dinámica

Dinámica es una rama de la física que estudia la relación entre las fuerzas que actúan sobre un cuerpo y los efectos que se producirán sobre el movimiento de los cuerpos.

La dinámica en el ámbito de la física está regulada por las Leyes de Newton lo cual obedece a 3 leyes: la primera ley, indica que un cuerpo se mantendrá en reposo o movimiento uniforme excepto que sobre el cuerpo actúe una fuerza; la segunda ley, establece que la variación del movimiento de los cuerpos es proporcional a la fuerza que se ejerce sobre él; la tercera ley expresa que a la fuerza que se aplica sobre un cuerpo se le opone una fuerza de la misma intensidad pero en dirección opuesta.

Leyes de Newton

Sin lugar a dudas, Newton fue uno de los matemáticos más sobresalientes en la historia de la humanidad. Su principal legado son las llamadas "Leyes de Newton", las cuales dan una explicación muy distinta a lo que normalmente conocemos como sólo movimiento. Estas leyes fueron los primeros modelos fisicos propuestos por el hombre para explicar el movimiento.

La segunda Ley de Newton establece la relación entre la fuerza y el movimiento, en ella se establece que "si sobre un cuerpo de masa m se aplica una fuerza F, este cuerpo adquiere una aceleración a que es directamente proporcional a la fuerza aplicada". Esta Ley se sintetiza en la siguiente fórmula:

Se denomina Leyes de Newton a tres leyes concernientes al movimiento de los cuerpos. La formulación matemática fue publicada por Isaac Newton en 1687, en su obra Philosophiae Naturalis Principia Mathematica. Las leyes de Newton constituyen, junto con la transformación de Galileo, la base de la mecánica clásica. En el tercer volumen de los Principia Newton mostró que, combinando estas leyes con su Ley de la gravitación universal, se pueden deducir y explicar las Leyes de Kepler sobre el movimiento planetario.

Debe aclararse que las leyes de Newton tal como comúnmente se exponen, sólo valen para sistemas de referencia inerciales. En sistemas de referencia no-inerciales junto con las fuerzas reales deben incluirse las llamadas fuerzas ficticias o fuerzas de inercia que añaden términos suplementarios capaces de explicar el movimiento de un sistema cerrado de partículas clásicas que interactúan entre sí.

Primera ley de Newton o Ley de Inercia

En ocasiones, esta ley se nombra también Principio de Galileo.

- En la ausencia de fuerzas, todo cuerpo continúa en su estado de reposo o de movimiento rectilíneo y uniforme respecto de un sistema de referencia Galileano.

Este principio puede ser reformulado de la manera siguiente:

- Un sistema de referencia en el que son válidas las leyes de la física clásica es aquel en el cual todo cuerpo permanece en un estado de movimiento rectilíneo y uniforme en ausencia de fuerzas.

La Primera ley constituye una definición de la fuerza como causa de las variaciones de velocidad de los cuerpos e introduce en física el concepto de sistemas de referencia inerciales o sistemas de referencia Galileanos. Los sistemas no inerciales son todos aquellos sistemas de referencia que se encuentran acelerados.

Esta observación de la realidad cotidiana conlleva la construcción de los conceptos de fuerza, velocidad y estado. El estado de un cuerpo queda entonces definido como su característica de movimiento, es decir, su posición y velocidad que, como magnitud vectorial, incluye la rapidez, la dirección y el sentido de su movimiento. La fuerza queda definida como la acción mediante la cual se cambia el estado de un cuerpo.

En la experiencia diaria, los cuerpos están sometidos a la acción de fuerzas de fricción o rozamiento que los van frenando progresivamente. La no comprensión de este fenómeno hizo que, desde la época de Aristóteles y hasta la formulación de este principio por Galileo y Newton, se pensara que el estado natural de movimiento de los cuerpos era nulo y que las fuerzas eran necesarias para mantenerlos en movimiento. Sin embargo, Newton y Galileo mostraron que los cuerpos se mueven a velocidad constante y en línea recta si no hay fuerzas que actúen sobre ellos. Este principio constituyó uno de los descubrimientos más importantes de la física.

Segunda Ley de Newton o Ley de la Fuerza

- La variación del momento lineal de un cuerpo es proporcional a la resultante total de las fuerzas actuando sobre dicho cuerpo y se produce en la dirección en que actúan las fuerzas.

Newton definió el momento lineal (momentum) o cantidad de movimiento como una magnitud representativa de la resistencia de los cuerpos a alterar su estado de movimiento definiendo matemáticamente el concepto coloquial de inercia.

- ,

donde m se denomina masa inercial. La segunda ley se escribe por lo tanto:

Esta ecuación es válida en el marco de la teoría de la relatividad de Albert Einstein si se considera que el momento de un cuerpo se define como:

Substituyendo en la ecuación de la fueza, la definción de la cantidad de movimiento clásica la segunda ley de Newton adquiere la forma más familiar de:

- .

Esta ley constituye la definición operacional del concepto de fuerza, ya que tan sólo la aceleración puede medirse directamente. De una forma más simple, se podría también decir lo siguiente:

- La fuerza que actúa sobre un cuerpo es directamente proporcional al producto de su masa y su aceleración.

Donde F es la fuerza aplicada, m es la masa del cuerpo y a la aceleración.

Tercera Ley de Newton o Ley de acción y reacción

- Por cada fuerza que actúa sobre un cuerpo, éste realiza una fuerza igual pero de sentido opuesto sobre el cuerpo que la produjo. Dicho de otra forma: Las fuerzas siempre se presentan en pares de igual magnitud y sentido opuesto.

Esta ley, junto con las anteriores, permite enunciar los principios de conservación del momento lineal y del momento angular.

Ley de acción y reacción fuerte

En la ley de acción y reacción fuerte, las fuerzas además de ser de la misma magnitud y opuestas, son colineales. La forma fuerte de la ley no se cumple siempre.

Ley de acción y reacción débil

En la ley de acción y reacción débil no se exige que las fuerzas de acción y reacción sean colineales, tan sólo de la misma magnitud y sentido opuesto, sin actuar necesariamente en la misma línea. Ciertos sistemas magnéticos no cumplen el enunciado fuerte de esta ley, y tampoco lo hacen las fuerzas eléctricas ejercidas entre una carga puntual y un dipolo. La forma débil de la ley de acción-reacción se cumple siempre. La cinemática de un punto se puede describir en un sistema de coordenadas cartesiano tridimensional con tres funciones que proporcionen la dependencia de cada una de ellas en función del tiempo.

En el caso del punto todas las fuerzas son concurrentes y se puede trabajar con la fuerza resultante , de la que se han de considerar sus tres componentes: , y . Derivando dos veces en función del tiempo y aplicando la segunda ley de Newton se encuentran las ecuaciones de la dinámica del punto.

Donde m es la masa del punto material.

Con estas ecuaciones se puede determinar completamente la cinemática de la masa puntual considerada.

Referencias

Discusión

Si se considera un sistema de puntos, la fuerza resultante sobre el punto i de todas las fuerzas, internas y externas, que actúan sobre el es:

donde es la resultante de todas las fuerzas internas del sistemas y la de todas las fuerzas externas.

Sumando para todas las particulas a considerar se obtiene un resultante para el sistema completo de partículas:

La ecuación anterior se puede simplificar dado que por el principio de acción y reacción sabemos que a toda fuerza interna sobre el punto i le ha de corresponder otra igual y de sentido opuesto ejercida en otro punto j, por lo que el primer sumatorio de la parte izquierda de la igualdad se anula, quedando solamente las fuerzas externas al sistema:

Si realizamos el ejercicio de considerar una masa puntal sometida a la misma fuerza que la resultante de fuerzas externas del sistema completo y con una masa igual a la masa total del sistema, podremos escribir:

donde vec{R} es el vector de posición del punto imaginario considerado y

Lo que inspira las siguientes definiciones.

Definición de centro de masas

El centro de masas de un sistema de puntos es el punto geométrico donde la resultante de las fuerzas ejercidas por todos los cuerpos del sistema se anula.

En un tratamiento de sistemas de masas puntuales el centro de masas es el punto donde se supone concentrada toda la masa del sistema. El concepto se utiliza para análisis físicos en los cuales no es importante considerar la distribución de masa. Por ejemplo, en las órbitas de los planetas.

Cálculo del CM de un sistema de masas discreto

Cálculo del CM de un sistema de masas continuo

Casos particulares en un sistema continuo

- Distribución de masa homogénea: Si la masa está distribuida homogéneamente, la densidad será constante por lo que se puede sacar fuera de la integral haciendo uso de la equivalencia

- Nota: V es el volumen total. Para cuerpos bidimensionales o monodimensionales se trabajará con densidades superficiales/longitudinales y con superficies/longitudes.

- - Para el caso de cuerpos con geometría regular tales como esferas, paralelepípedos, cilindros, etc. el CM coincidirá con el centro geométrico del cuerpo.

- Distribución de masa no homogénea: Los centros de masas en cuerpos de densidad variable pueden calcularse si se conoce la función de densidad . En este caso se calcula el CM de la siguiente forma.

- - La resolución de la integral dependerá de la función de la densidad.

Interpretación física del centro de masas

El centro de masa de un sistema es un punto que se comporta dinámicamente como si todas las fuerzas externas del sistema actuasen directamente sobre el.

Referencias

Rotación es el movimiento de cambio de orientación de un cuerpo extenso de forma que, dado un punto cualquiera del mismo, este permanece a una distancia constante de un punto fijo. En un espacio tridimensional, para un movimiento de rotación dado, existe una línea de puntos fijos denominada eje de rotación.

La velocidad angular se expresa como el ángulo girado por unidad de tiempo y se mide en radianes por segundo. Otras unidades que se pueden utilizar son Hercios (ciclos por segundo) o revoluciones por minuto (rpm). Comúnmente se denomina por las letras: u . La rotación es una propiedad vectorial de un cuerpo. El vector representativo de la velocidad angular es paralelo a la dirección del eje de rotación y su sentido indica el sentido de la rotación siendo el sentido horario negativo y el sentido antihorario positivo. En ocasiones se utiliza también la frecuencia como medida escalar de la velocidad de rotación.

El grado de variación temporal de la frecuencia angular es la aceleración angular (rad/s²) para la cual se utiliza frecuentemente el símbolo .

Período y frecuencia: Estos parámetros son de uso frecuente en sistemas rotantes a velocidad constante. El período es el inverso de la frecuencia y representa el tiempo que se tarda en dar una revolución completa. Período y frecuencia se representan respectivamente como:

- Período:

- Frecuencia:

Transformaciones de rotación

En matemáticas las rotaciones son transformaciones lineales que conservan las normas en espacios vectoriales en los que se ha definido una operación de producto interior. La matriz de transformación tiene la propiedad de ser una matriz unitaria, es decir, es ortogonal y su determinante es 1.

Sea un vector A en el plano cartesiano definido por sus componentes x e y, descrito vectorialmente a través de sus componentes:

La operación de rotación del punto señalado por este vector alrededor de un eje de giro puede siempre escribirse como la acción de un operador lineal (representado por una matriz) actuando sobre el vector (multiplicando al vector) .

En dos dimensiones la matriz de rotación para el vector dado puede escribirse de la manera siguiente:

.

Al hacer la aplicación del operador, es decir, al multiplicar la matriz por el vector, obtendremos un nuevo vector A' que ha sido rotado en un ángulo en sentido horario: , es decir

donde y son las componentes del nuevo vector después de ser rotado.

Teorema de rotación de Euler

El teorema de rotación de Euler dice que cualquier rotación o conjunto de rotaciones sucesivas puede expresarse siempre como una rotación alrededor de una única dirección o eje de rotación principal. De este modo, toda rotación (o conjunto de rotaciones sucesivas) en el espacio tridimensional puede ser especificada a través del eje de rotación equivalente definido vectorialmente por tres parámetros y un cuarto parámetro representativo del ángulo rotado. Generalmente se denominan a estos cuatro parámetros grados de libertad de rotación.

Referencias

Rotación alrededor de un eje fijo es un caso especial del movimiento rotacional. La hipótesis del eje fijo excluye la posibilidad de un eje en movimiento, y no puede describir fenómenos como el “bamboleo”.

De acuerdo al teorema de la rotación de Euler, la rotación alrededor de más de un eje al mismo tiempo es imposible, así pues, si dos rotaciones son forzadas al mismo tiempo en diferente eje, aparecerá un nuevo eje de rotación.

Las siguientes fórmulas y conceptos son útiles para comprender más a fondo la rotación sobre un eje fijo.

Relación entre el movimiento de rotación y el lineal

El movimiento de rotación tiene una estrecha relación con el movimiento lineal.

El desplazamiento lineal es el producto del desplazamiento angular por el radio del círculo descrito por el movimiento.

- s=θR

La velocidad lineal es el producto de la velocidad angular por el radio del círculo descrito por el movimiento.

- v=ωR

La aceleración tangencial es el producto de la aceleración angular por el radio del círculo descrito por el movimiento.

- a=αR

Así mismo, tomando en cuenta lo anterior, las fórmulas de la cinemática mantienen esta misma relación.

Mientras que las fórmulas de la cinemática del movimiento lineal son:

Para la cinemática del movimiento rotacional utilizaremos las siguientes:

- ω_f ^2 = ω_o ^2 + 2αθ

- ω_f=ω_o+αt

- θ=ω_o t+1/2 αt^2

Desplazamiento angular θ

El desplazamiento angular de un objeto determina la cantidad de rotación del mismo y es descrito por la siguiente fórmula:

- ∆θ=θ_2-θ_1

El desplazamiento angular se mide en radianes (rad), aunque también se puede medir en revoluciones (rev). A continuación se presentan la comparación entre unidades.

- 1 rad = 57.3° 1 rev = 360° = 2π rad

Velocidad angular ω

La velocidad angular es el cambio del desplazamiento angular con respecto al tiempo, como se presenta en la siguiente fórmula:

- ω= ∆θ/∆t =(θ_2-θ_1)/(t_2-t_1 )

La velocidad angular, es siempre la misma sin importar la distancia que haya entre una partícula y el eje de rotación.

Las unidades en que se expresa comúnmente la velocidad angular es en radianes por segundo (rad/s), pero también puede expresarse en revoluciones por minuto (rpm o rev/min) y en revoluciones por segundo (rev/s).

Aceleración angular α

Al igual que en el movimiento lineal, el movimiento rotacional puede tener aceleración. La velocidad angular puede alterarse por la influencia de un momento de torsión resultante.

La fórmula para calcular la aceleración angular es la siguiente:

Momento de torsión (torque)

En la ley del movimiento rotacional, Newton menciona lo siguiente:

| Un momento de torsión resultante aplicado a un cuerpo rígido siempre genera una aceleración angular que es directamente proporcional al momento de torsión aplicado e inversamente proporcional al momento de inercia del cuerpo. [1] |

Energía cinética rotacional.

Tomando en cuenta que la energía cinética lineal está dada por la siguiente fórmula:

- K=1/2 mv^2

Y manteniendo la misma relación que ya se expresó más arriba, la energía cinética rotacional está dada por la fórmula:

- K=1/2 mω^2 R^2

Pero, si consideramos que un cuerpo está formado por diversas partículas de masas diferentes y localizadas a diferentes distancias del eje de rotación, la energía cinética total del cuerpo sería la sumatoria de las energías cinéticas de todas las partículas del cuerpo.

- K_T=∑▒〖1/2 mω^2 R^2 〗

Y tomando en cuenta que la velocidad angular es la misma para todas las partículas, la fórmula podríamos ordenarla de la siguiente manera:

- K_T=1/2 ω^2 (∑▒〖mR^2 〗)

Viendo que la cantidad en paréntesis no considera si la partícula está en movimiento o en reposo, definiremos a esa cantidad como momento de inercia.

Momento de inercia

La inercia es una propiedad de la materia para resistirse a cualquier cambio en su estado, ya sea de reposo o de movimiento como lo describe la Primera Ley de Newton:

| Un cuerpo permanece en estado de reposo o de movimiento rectilíneo uniforme, a menos que una fuerza externa no equilibrada actúe sobre él. Primera Ley de Newton[2]

|

Todos los cuerpos que giran alrededor de un eje desarrollan una inercia a la rotación (se resisten a cambiar su velocidad de rotación y la dirección de su giro. La inercia de un cuerpo a la rotación está determinada por su momento de inercia, que es la resistencia que opone un cuerpo en rotación al cambio de su velocidad de rotación.

La fórmula para calcular el momento de inercia de un cuerpo compuesto por partículas de masas dispersas es la siguiente:

- I=∑▒〖mR^2〗

Para calcular el momento de inercia de cuerpos con distribuciones parejas de masa, se utilizan fórmulas específicas para cada cuerpo. Algunos de los más comunes son los siguientes:

- Aro delgado:

- Aro delgado alrededor de uno de sus diámetros :

- Disco sólido:

- Cilindro sólido:

- Cilindro hueco:

- Barra delgada con eje a través de su centro :

- Barra delgada con eje en uno de sus extremos:

- Esfera sólida con eje en su diámetro:

- Esfera hueca de pared delgada:

Dada la fórmula del momento de inercia, podemos darnos cuenta de que la unidad en que se mide la inercia es en kilogramo-metro al cuadrado (kg m²).[3]

Referencias

- ↑ Tippens, Paul (2001). «11» (en español). FÍSICA CONCEPTOS Y APLICACIONES (sexta edición). McGraw-Hill. pp. 253.

- ↑ Tippens, Paul (2001). «4» (en español). FÍSICA CONCEPTOS Y APLICACIONES (sexta edición). McGraw-Hill. pp. 74.

- ↑ Tippens, Paul (2001). «11» (en español). FÍSICA CONCEPTOS Y APLICACIONES (sexta edición). McGraw-Hill. pp. 241-259.

Uno de los tipos de movimiento con los que nos encontramos son movimientos repetitivos en los que la posición del objeto que se se muevo vuelve a su posición original. La situación de estos tipos de movimiento que es más fácil de analizar es el que transcurre en un plano. Para estudiarlo es útil definir una serie de magnitudes angulares.

Definición de radián

Si consideramos un punto que describe algún tipo de movimiento rotatorio y tomamos el segmento que una un punto interior a la trayectoria y el punto móvil, nos daremos cuenta que dicho segmento barre un ángulo hasta que se repite la posición original y el ángulo recorrido es de 360º.

Si bien la medición del ángulo en grados sexagesimales es una posibilidad para el estudio de la cinemática de la rotación, resulta más conveniente otra unidad, conocida como radian. Para definirlo consideremos un segmento de longitud constante que barre la superficie de un círculo. Si llamamos a la longitud del arco de circunferencia correspondiente al ángulo barrido en un tiempo y la longitud del segmento considerado, el ángulo en radianes es . Para un círculo completo es la longitud de la circunferencia y por tanto el número de radianes de un círculo completo es .

Coordenadas angulares

La coordenada fundamental para el estudio de la cinemática de la rotación es el ángulo , de la que se derivan otras dos magnitudes: la velocidad angular y la acelaración angular.

Velocidad angular: El módulo de la velocidad angular se define como

su dirección es la perpendicular al plano del movimiento y el sentido el definido por la w:regla de la mano derecha.

Aceleración angular: De forma análoga a la aceleración lineal, se define la aceleración angular como

Relación entre magnitudes lineales y angulares

En el caso estudiado de un partícula que describe un movimiento circular se puede determinar la velocidad lineal como

siendo un vector unitario tangencial a la trayectoria circular. La descripción de dicho vector unitario y el vector unitario radial en coordenadas cartesianas es

siendo el ángulo entre el radio que describe el movimiento de la partícula y el eje X.

Las derivadas con respecto al tiempo de los vectores unitarios son

y

Referencias

- Gettys, W. Edward, Keller, Frederick J., Skove, Malcom J. (1995). Física Clásica y Moderna. 84-7615-635-9.

Rotación en sólidos rígidos

En general se utiliza un cuerpo sólido ideal no puntual e indeformable denominado sólido rígido como ejemplo básico para estudiar los movimientos de rotación de los cuerpos. La velocidad de rotación está relacionada con el momento angular. Para producir una variación en el momento angular es necesario actuar sobre el sistema con fuerzas que ejerzan un momento de fuerza. La relación entre el momento de las fuerzas que actúan sobre el cuerpo y la aceleración angular se conoce como momento de inercia (I) y representa la inercia o resistencia del cuerpo a alterar su movimiento de rotación.

Cinemática de la rotación de sólidos rígidos: Para analizar el comportamiento cinemático de un cuerpo rígido debemos partir de la idea de que un angulo θ define la posición instantánea de cualquier partícula contenida en el cuerpo rígido (CR); este angulo se mide desde un plano perpendicular al eje de rotación del CR.

Si la posición queda completamente definida por la coordenada angular θ, entonces la velocidad del CR se podrá expresar como:

Mientras que la aceleración quedaría definida por:

La energía cinética de rotación se escribe:

- .

La expresión del teorema del trabajo en movimientos de rotación se puede expresar así: la variación de la energía cinética del sólido rígido es igual al producto escalar del momento de las fuerzas por el vector representativo del ángulo girado ().

- .

Definición de momento de inercia

El momento de inercia o inercia rotacional es una magnitud que da cuenta de cómo es la distribución de masas de un cuerpo o un sistema de partículas alrededor de uno de sus puntos. Este concepto, desempeña en el movimiento de rotación un papel análogo al de la masa inercial en el caso del movimiento rectilíneo y uniforme.

Dado un eje arbitrario, para un sistema de partículas se define como la suma de los productos entre las masas de las partículas que componen un sistema, y el cuadrado de la distancia r de cada partícula a al eje escogido. Representa la inercia de un cuerpo a rotar. Matemáticamente se expresa como:

Para un cuerpo de masa continua (Medio continuo) lo anterior se generaliza como:

El subíndice V de la integral indica que hay que integrar sobre todo el volumen del cuerpo.

Este concepto, desempeña en el movimiento de rotación un papel análogo al de masa inercial en el caso del movimiento rectilíneo y uniforme. Así, por ejemplo, la segunda ley de Newton: tiene como equivalente para la rotación:

donde:

- es el momento aplicado al cuerpo.

- es el momento de inercia del cuerpo con respecto al eje de rotación y

- es la aceleración angular.

La energía cinética de un cuerpo en movimiento con velocidad v es , mientras que la energía de cinética de un cuerpo en rotación con velocidad angular ω es . Donde I es el momento de inercia con respecto al eje de rotación.

La conservación de la cantidad de movimiento o momento lineal tiene por equivalente la conservación del momento angular :

El vector momento angular tiene la misma dirección que el vector velocidad angular .

Momentos de inercia de cuerpos simples

| Descripción | ||

|---|---|---|

| varilla respecto a un eje que pasa por su centro | ||

| anillo delgado respecto al eje | ||

| anillo delgado respecto a un diámetro | ||

| cilindro macizo respecto a su eje de revolución | ||

| esfera respecto a un diámetro |

Tensor de inercia de un sólido rígido

El tensor de inercia de un sólido rígido, es un tensor simétrico de segundo orden, que expresado en una base ortonormal viene dado por una matriz simétrica, dicho tensor se forma a partir de los momentos de inercia según tres ejes perpendiculares y tres productos de inercia tal como se explica a continuación.

Tal como se explica al principio del artículo, para un sólido rígido tridimensional pueden definirse momentos de inercia según diversos ejes, en particular pueden definirse según tres ejes perpendiculares prefijados indepedientes que llamaremos X, Y y Z:

Además de estas magnitudes pueden definirse los llamados productos de inercia:

Todas las formas anteriores pueden resumirse en la siguiente fórmula tensorial:

Donde y donde .

El momento con respecto a cualquier otro eje puede expresarse como combinación lineal anterior de las anteriores magnitudes:

Donde la matriz anterior es el tensor de inercia expresado en la base XYX y t = (tx, ty, tz) es el vector paralelo al eje según el cual se pretende encontrar el momento de inercia.

Derivación formal del tensor de inercia

La velocidad de un cuerpo rígido se puede escribir como la suma de la velocidad del centro de masa más la velocidad de un elemento del sólido, matemáticamente esto es

donde es la velocidad, es la velocidad del centro de masa, es la velocidad angular medida en un sistema solidario al sólido y es la distancia entre el orígen de este sistema y el elemento del sólido. Si se toma la norma al cuadrado de este vector se puede obtener la energía cinética de dicho diferencial de cuerpo rígido, a saber

donde , con la densidad del cuerpo y un elemento de volumen. Para obtener la energía cinética total del cuerpo rígido se debe integrar en todo el volumen de éste:

Con el fin de anular el último término, i. e. simplificar la expresión (y las sucesivas), se elige el origen del sistema solidario al sólido en el centro de masa. De este modo

pues, en virtud de la elección hecha . Se tiene luego que

es evidente, que el primer término el la energía cinética debido a la traslación del cuerpo. El otro término, en consecuencia, debe ser la energía asociada a la rotación del mismo. Si se escribe explícitamente el integrando de este último término se tiene

donde es claro que:

con la delta de Kronecker. Poniendo este resultado en la expresión asociada a la energía cinética debido a la rotación y poniendo la integral dentro de la sumatoria se tiene

Debe notarse que el factor correspondiente a la integral depende únicamente de las característica geométricas (físicas) del cuerpo. En efecto, depedende de su forma (volumen) y de la masa del cuerpo y de como cómo está distribuida en dicha forma. Este factor es la componente de un cierta matriz que se conoce como Tensor de Inercia, puesto que toda matriz corresponde a un tensor de segundo rango:

A los elementos se los llama momento de inercia respecto del eje . Claramente, se ve que el tensor de inercia es simétrico, por lo tanto es siempre diagonalizable. Es decir, siempre se puede encontrar una base de vectores tal que dicha matriz tenga forma diagonal. Tales vectores definen lo que se conoce como ejes principales. En otras palabras, siempre se puede elegir un sistema completo de vectores ortonormales (ejes principales) con los cuales el tensor de incercia toma forma diagonal.

Concepto de Momento Angular

El momento angular, en el contexto de las rotaciones, se refiere a la cantidad de movimiento rotacional que posee un objeto al girar alrededor de un eje. Este concepto es fundamental para comprender la conservación del momento angular, la estabilidad de sistemas giratorios y la transferencia de energía en sistemas rotacionales.

Aplicaciones en la Física

En el ámbito de la física, el momento angular es esencial para describir fenómenos como el movimiento de planetas, el giro de partículas subatómicas y la dinámica de sistemas rotativos. La comprensión del momento en las rotaciones permite explicar la conservación de la cantidad de movimiento en sistemas a escala microscópica y macroscópica.

Ingeniería y Tecnología

En ingeniería, el momento angular es crucial para el diseño y análisis de sistemas rotativos, como motores, turbinas y dispositivos mecánicos. La aplicación del momento angular en ingeniería permite optimizar la eficiencia y estabilidad de máquinas y mecanismos que operan mediante el movimiento rotacional.

Vida Cotidiana

En la vida cotidiana, el momento en las rotaciones se manifiesta en actividades que van desde el giro de ruedas en vehículos hasta el funcionamiento de dispositivos eléctricos y electrónicos. Comprender el momento angular es fundamental para el diseño y operación segura de tecnologías presentes en la vida diaria.

Conclusión

En resumen, el momento en las rotaciones es un concepto esencial en la descripción y comprensión de fenómenos físicos, ingenieriles y cotidianos que involucran movimiento rotacional. Su aplicación permite abordar la conservación de la cantidad de movimiento en sistemas giratorios, lo que tiene implicaciones significativas en el desarrollo de tecnologías y la comprensión de la naturaleza. El momento angular o momento cinético de una masa puntual, es igual al producto vectorial del vector de posición (brazo), del objeto en relación a la recta considerada como eje de rotación, por la cantidad de movimiento (también llamado momento lineal o momento). Frecuentemente se lo designa con el símbolo :

En ausencia de momentos de fuerzas externos, el momento angular de un conjunto de partículas, de objetos o de cuerpos rígidos se conserva. Esto es válido tanto para partículas subatómicas como para galaxias.

Momento angular de una masa puntual

En el dibujo de derecha vemos una masa que se desplaza con una velocidad instantánea . El momento angular de esta partícula, con respecto a la recta perpendicular al plano que contiene y es, como ya se ha escrito:

El vector es perpendicular al plano que contiene y , luego es paralelo a la recta considerada como eje de rotación. En el caso del dibujo, el vector momento angular sale del dibujo y va hacia el observador.

El módulo del momento angular es:

Es decir, el módulo es igual al momento lineal multiplicado por su brazo, el cual es la distancia entre el eje de rotación y la recta que contiene la velocidad de la partícula. Por esta razón, algunos designan el momento angular como el "momento del momento".

Dependencia temporal

Derivemos el momento angular con respecto al tiempo:

El primero de los paréntesis es cero ya que la derivada de con respecto al tiempo no es otra cosa que la velocidad . Y como el vector velocidad de paralelo al vector cantidad de movimiento , el producto vectorial de los dos es cero. Nos queda el segundo paréntesis:

donde es la aceleración. Pero , la fuerza aplicada a la masa. Y el producto vectorial de por la fuerza es el torque o momento de fuerza aplicado a la masa:

La derivada temporal del momento angular es igual al torque aplicado a la masa puntual.

Momento angular de un conjunto de partículas

El momento angular de un conjunto de partículas es la suma de los momentos angulares de cada una:

La variación temporal es:

El término de derecha es la suma de todos los torques producidos por todas las fuerzas que actúan sobre las partículas. Una parte de esas fuerzas puede ser de origen externo al conjunto de partículas. Otra parte puede ser fuerzas entre partículas. Pero cada fuerza entre partículas tiene su reacción que es igual pero de dirección opuesta y colineal. Eso quiere decir que los torques producidos por cada una de las fuerzas de un par acción-reacción son iguales y de signo contrario y que su suma se anula. Es decir, la suma de todos los torques de origen interno es cero y no puede hacer cambiar el valor del momento angular del conjunto. Solo quedan los torques externos:

El momento angular de un conjunto de partículas se conserva en ausencia de torques externos.

Esta afirmación es válida para cualquier conjunto de partículas: desde núcleos atómicos hasta grupos de galaxias.

Cuerpos rígidos

Cuando el conjunto de partículas forma un cuerpo rígido, sabemos que

donde:

- es el torque aplicado al cuerpo.

- es el momento de inercia del cuerpo.

- es la aceleración angular del cuerpo.

Luego:

Como el momento angular es cero si no hay rotación: